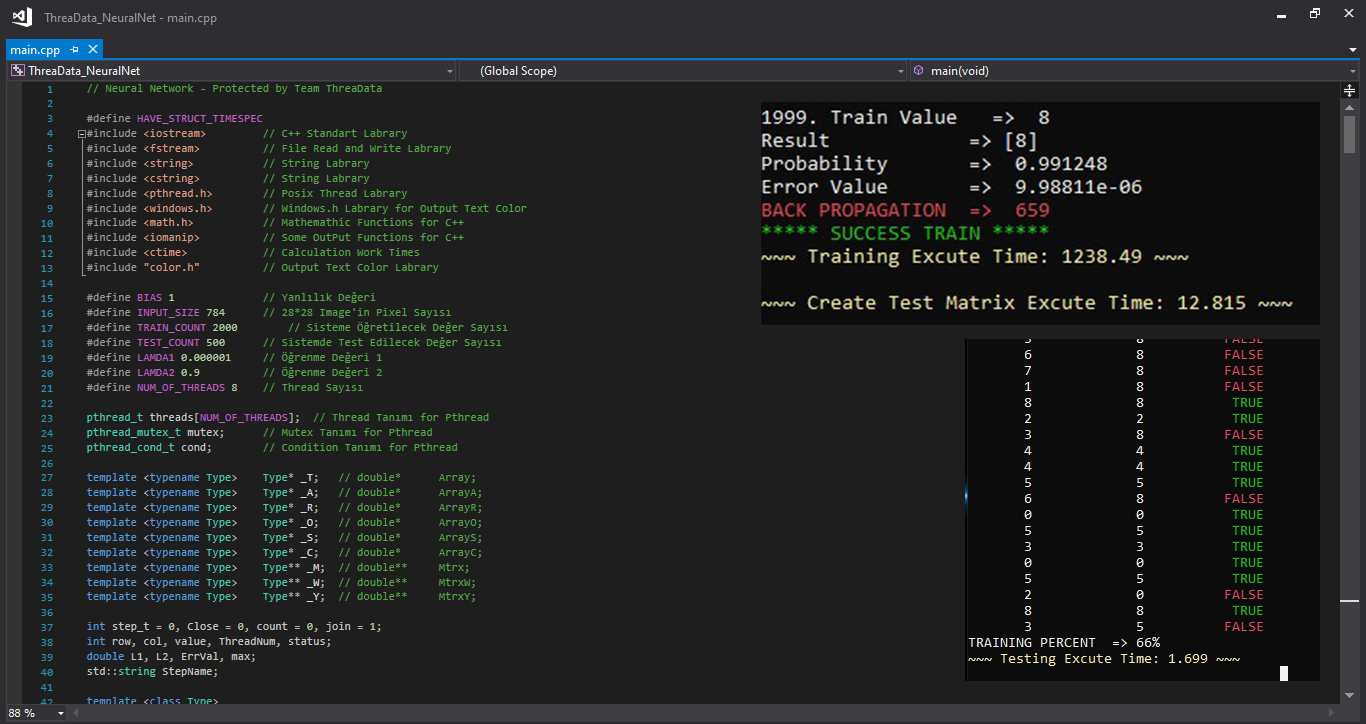

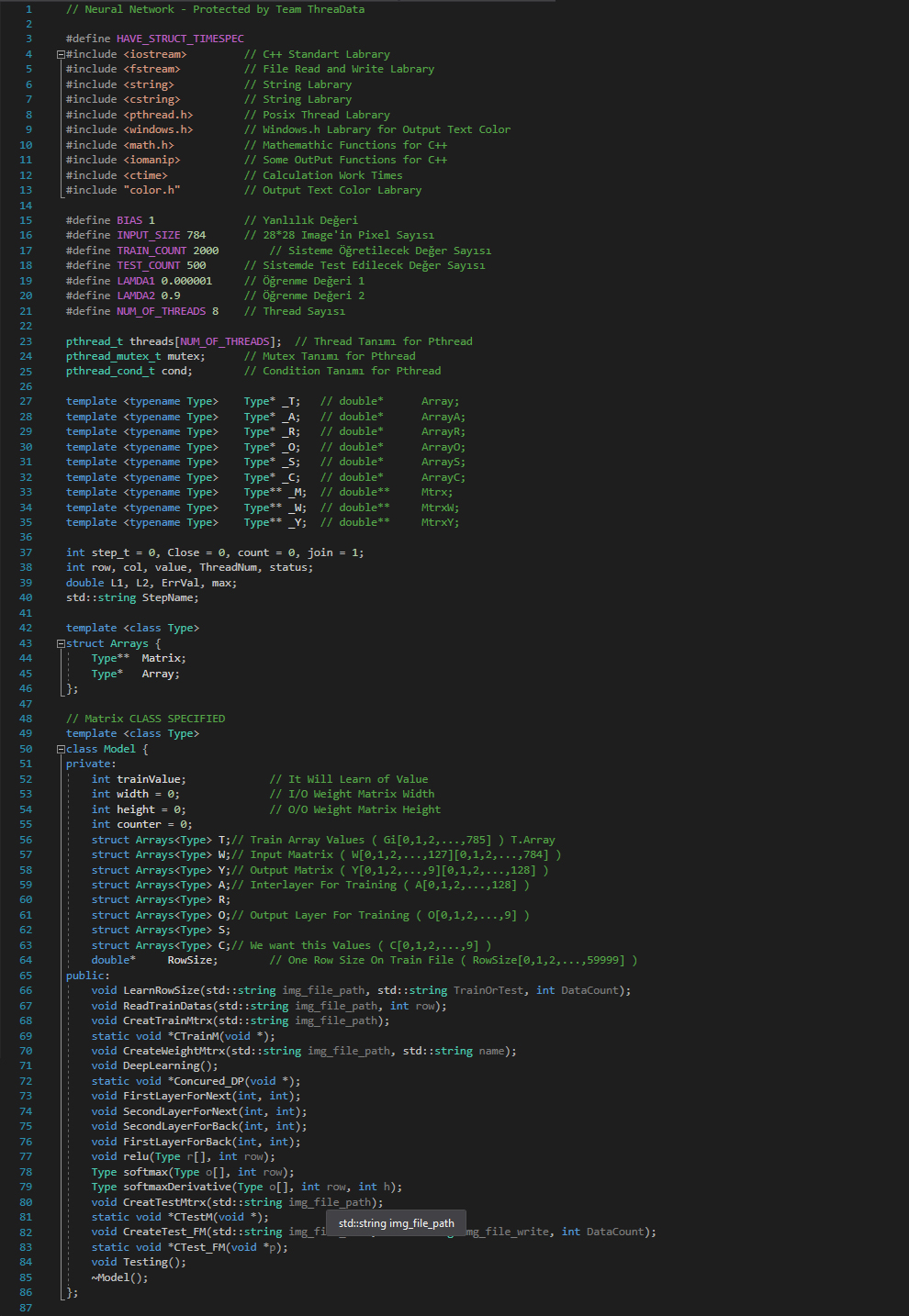

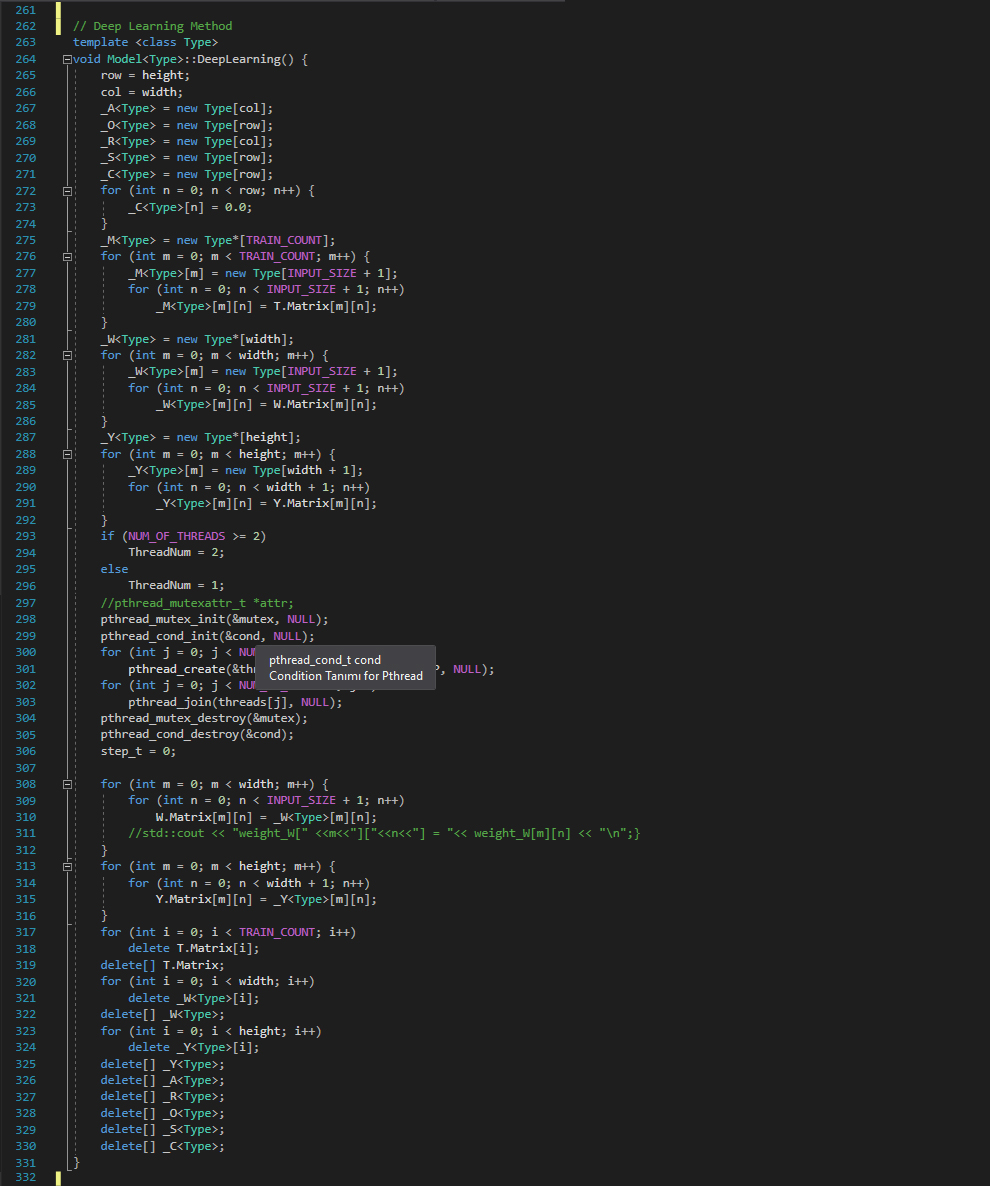

DeepLearning() Methodu

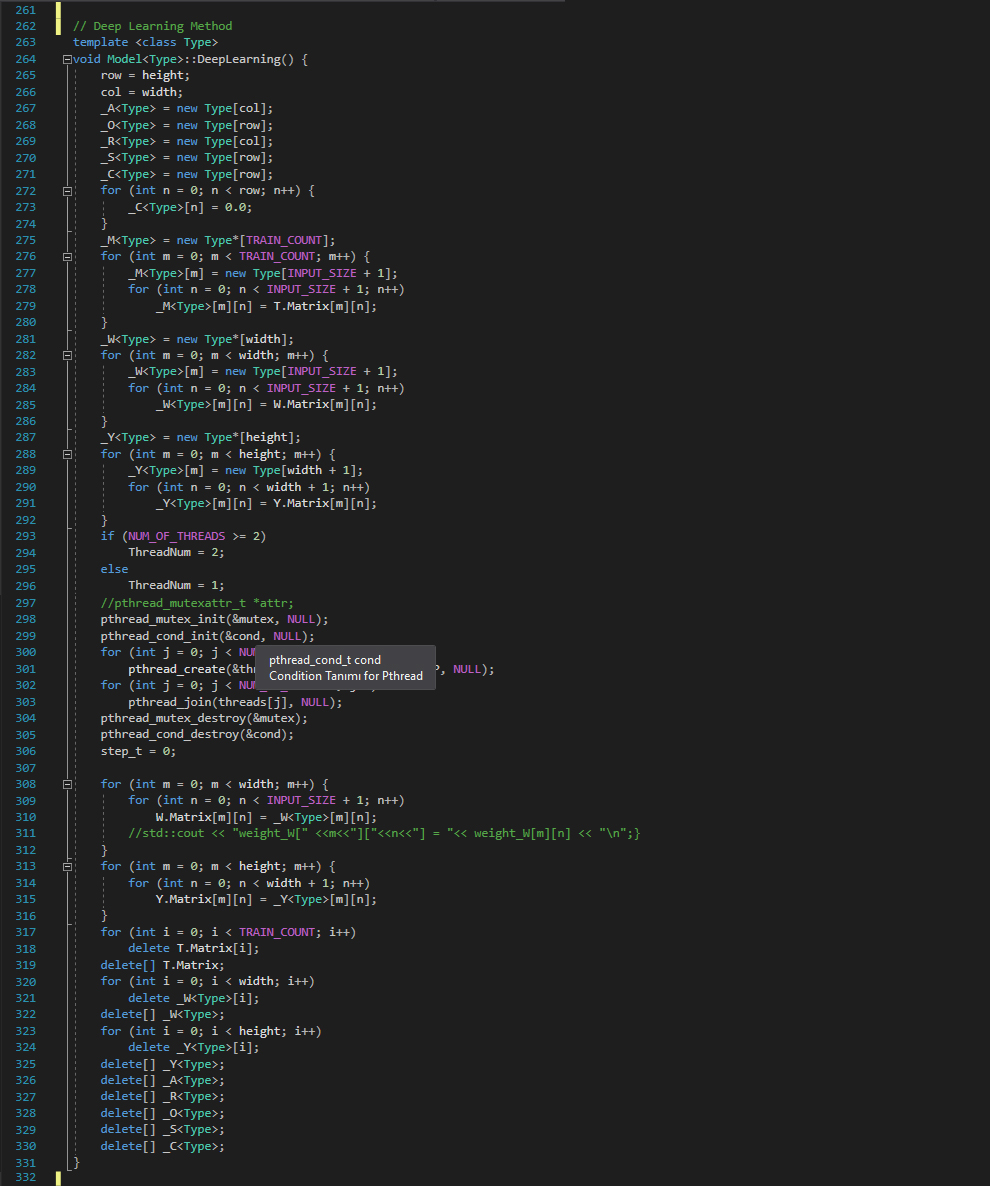

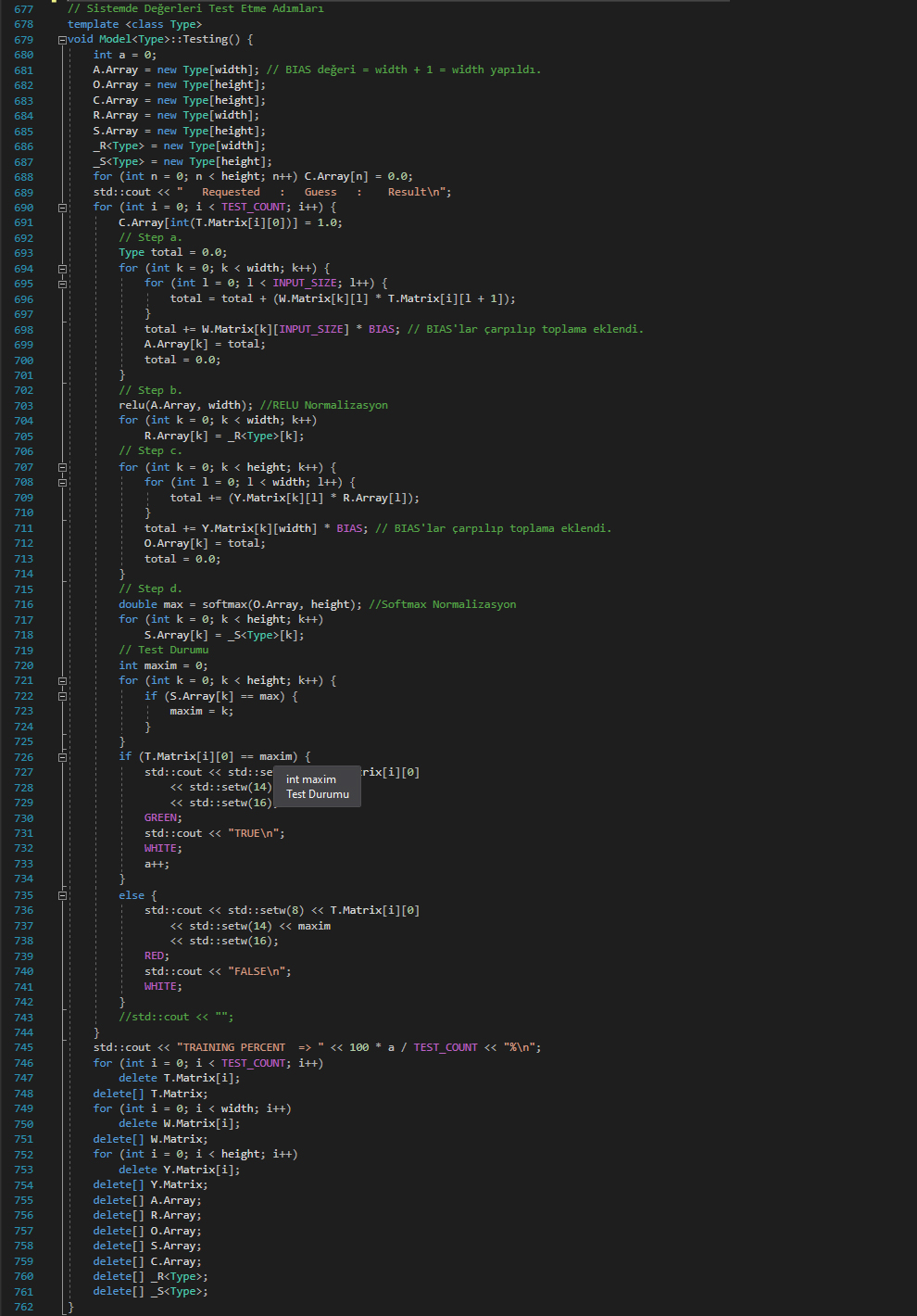

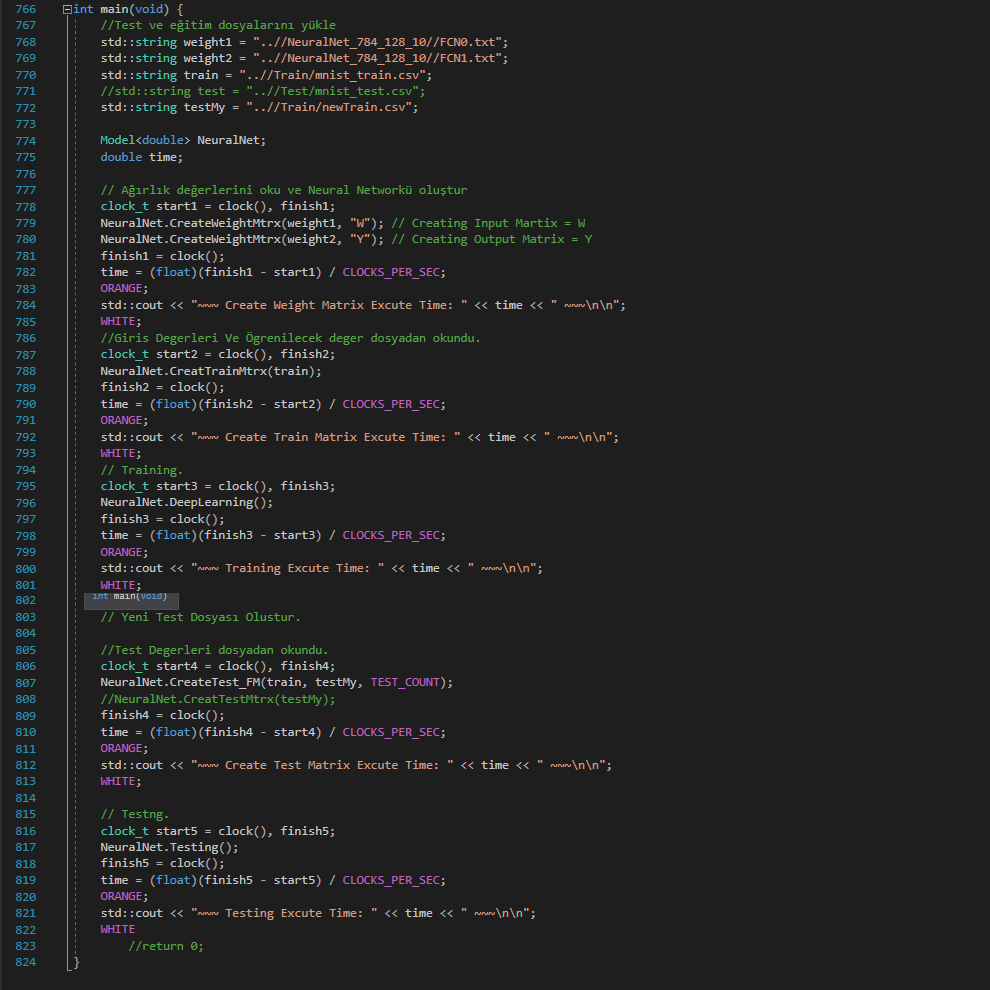

Bu methodumuzla sisteme öğretme yani öğrenme adımına başlıyoruz. Burdaki amaç input değerlerimizi 1. ve 2. ağırlık matrislerimizi kullanarak sonuç olarak 10 elemanlı bir dizi elde edeceğiz ve bu dizimizi istenen dizimizle kıyaslayıp bir hata değeri bulacağız. Eğer bulduğumuz hata değeri 10^-5 ten küçükse öğretme işlemi(sistemin öğrenme işlemi) o resim için tamam demektir. Fakat hata değerimiz 10^-5 ten büyükse, geri yayılım uygulamamız gerekiyor. 1. ve 2. ağırlık matrislerimizi güncelleyerek tekrar ileri yayılım yapmalıyız. İleri yayılım sonucunda yeni bulacağımız 10 elemanlı dizimizi istenen dizimizle tekrar kıyaslayıp yeni hata değeri hesaplayacağız. Bu döngü hata değerini istediğimiz seviyeye çekene kadar devam edecektir.

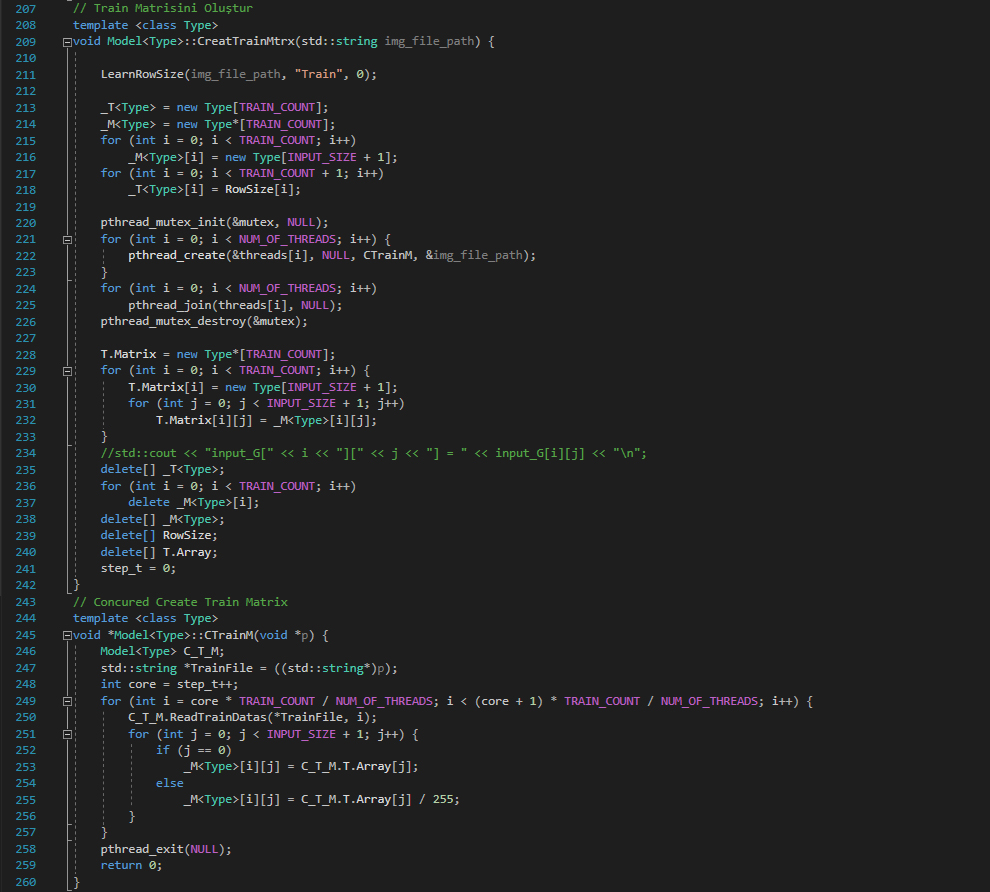

DeepLearning() methodumuzda ilk olarak global tanımlanan matrislerimiz ve dizilerimizi dinamik oluşturuyoruz. Üye fonksiyonlar ile paralelleştirme yapabildiğimiz için üye fonksiyonu içinden Class'ın elemanlarına ulaşamıyoruz. Bu yüzden global değişkenler, diziler, matrisler ile işlemlerimizi yapıp, işi biteni class elemanlarına atayacağız ve global dizi veya matrisleri silme(delete) işlemi uygulayacağız.

Sonrasında "pthread_create()" ile threadlerimizi oluşturuyoruz ve ilgili üye fonksiyona yönlendiriyoruz. Threadler işlerini bitirince "pthread_join()" ile bir toplanma alanı belirtiyoruz.

"pthread_create" işleminden önce tanımlanan "pthread_mutex_init" ile üye fonksiyonumuzda kullanacağımız olan mutex'i başlatıyoruz. "pthread_cond_init" ile de yine üye fonksiyonumuzda kullanacağımız olan condition'u başlatıyoruz.

Mutex bize birbirini dışlama (Mutually Exclusive) sağlar. Yani threadlerimizi senkronize edeceğiz fakat birbirine karışmamaları gerekiyor. Mutex bu karışmayı engelliyor diyebiliriz.

Cond bize yarış (condition) durumundan kurtulmamızda işe yarıyor. Yarış dediğimiz olay, threadlerin aynı veriye ulaşmak istemesi durumunda birbirleri ile yarış haline düşebilirler ve program bu yarış durumundan gecikmelere yada kilitlenmelere düşebilir. Bunu cond ile önlüyoruz.

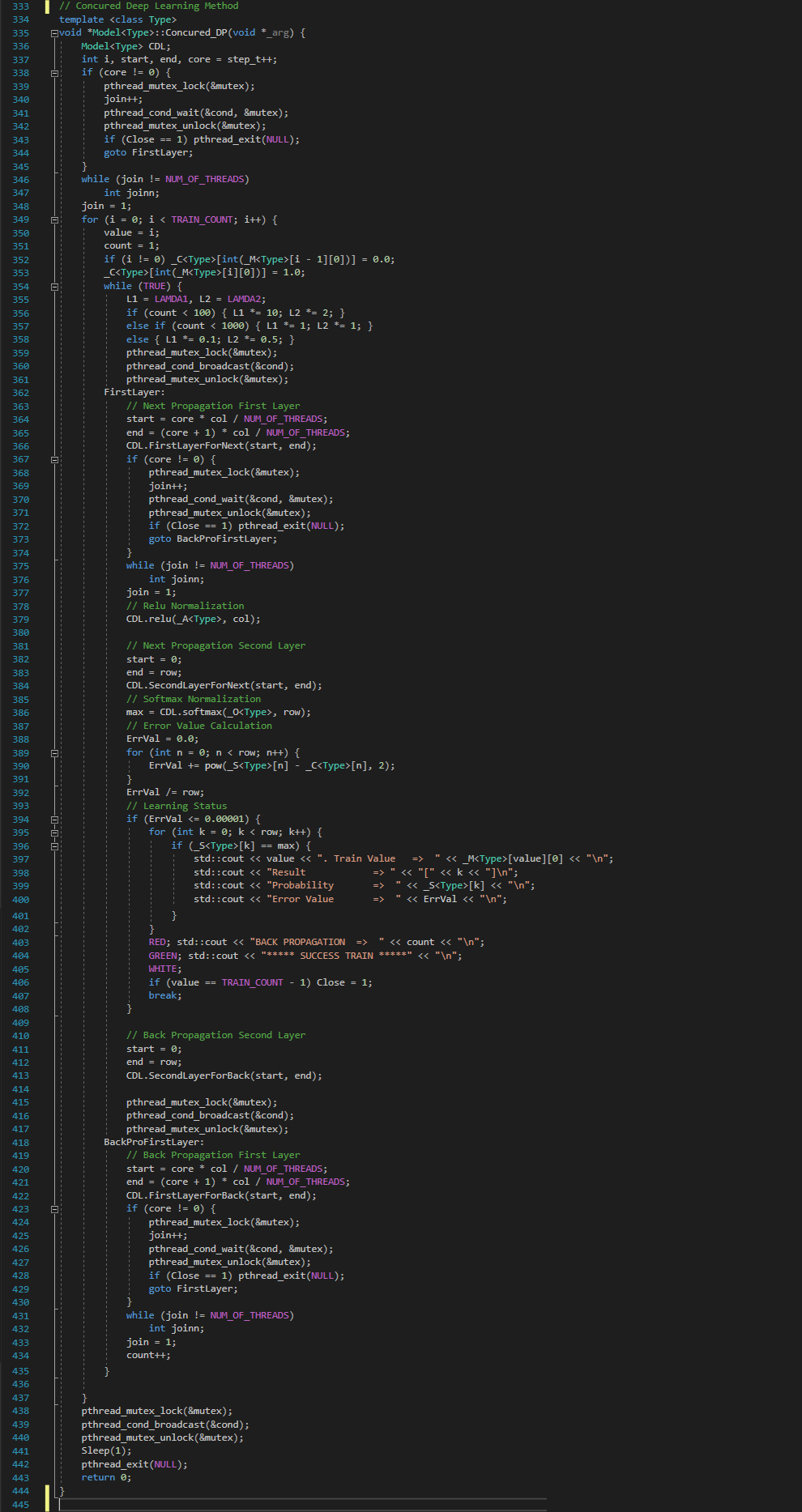

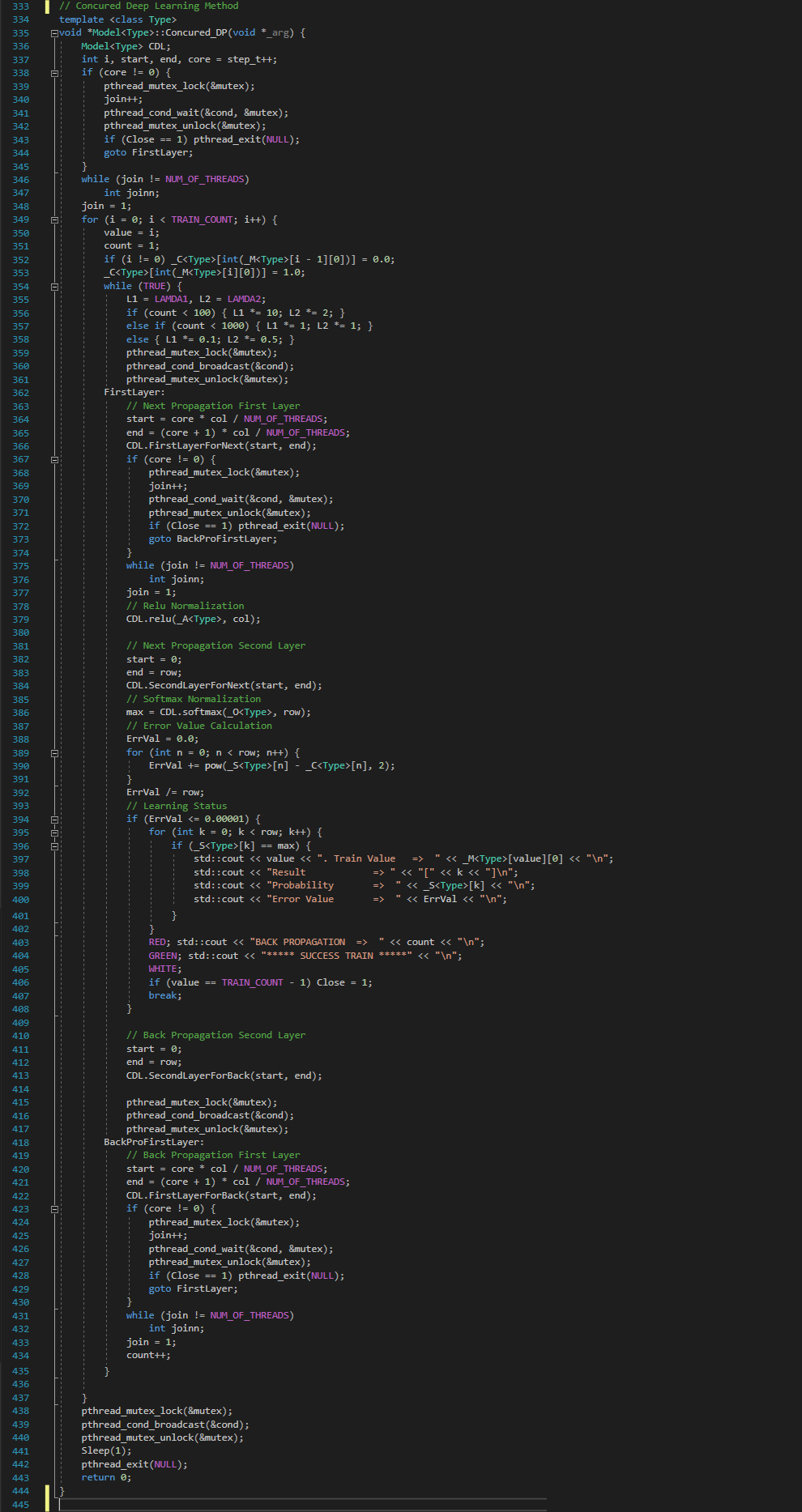

Üye Method Concured_DP() Methodu

Öğrenme aşamasındaki üye methodumuza ulaşmış bulunmaktayız.

Bu methodta ileri yayılım ve geri yayılım adımlarını gereçekleştireceğiz.

İleri yayılımın ilk adımı olan 1 resim için elde ettiğimiz input verileri ile 1. ağırlık matrisimizi çarpıyoruz. ([128][785]*[785][1] = [128][1]) Bu işlemi "FirstLayerForNext(start, end)" methodu ile gerçekleştiriyoruz. Satır sayısına göre threadlerimizi eşit pay ediyoruz. Yani blok veri paylaşımı yapmış oluyoruz.

Bu işlemin sonucunda elimizde 128 elemanlı bir ara katman A[] dizisi elde ediyoruz. Bu A[] dizimize relu normalizasyon "relu(_A< Type >, col)" methoduyla uyguluyoruz ve default tanımlı BIAS değerini dizimize ekliyoruz.

Elimizde yeni ara katman R[] dizisi oluşuyor. İleri yayılımdaki 1. katmanı tamamlamış olduk. Sırada 2. katman adımları var.

R[] dizimiz ile 2. Ağırlık matrisimizi çarpıyoruz([10][129]*[129][1] = [10][1]). Bu çarpma işlemini "SecondLayerForNext(start, end)" methodu ile gerçekleştiriyoruz.

Bu işlemin sonucunda elimizde 10 elemanlı çıktı O[] dizisi elde ediyoruz. O[] dizisine softmax normalizasyon "softmax(_O< Type >, row)" methodu kullanarak uyguluyoruz. Elimizde yeni çıktı S[] dizimiz oluşuyor. Bu S[] dizimiz 0 ile 1 arasında değerler almaktadır ve içlerinden sadece bir tanesi 1'e çok yakındır, diğerleri 0'a yakındır.

Bu aşamadan sonra bir hata değeri hesaplamamız gerekiyor. Hata değerini çıkış dizimizden istenen dizi değerlerini farkının karelerinin toplamını alarak ortalamasını alıyoruz. Yani pow(S[i] - C[i], 2) tüm indislerinin toplamının ortalaması.

Burdaki hata değerimiz 10^-5 ten küçükse öğretme o resim için tamamlanmıştır. büyükse geri yayılım işlemine başlıyoruz.

Geri yayılım adımlarına terstten başlıyoruz. Yani 2 katmandan başlayarak ilk 2. Ağırlık matrisimizi sonrasında 1. katmandan devam ederek 1.Ağırlık matrisimizi güncelleyeceğiz.

Geri yayılımda zincirleme kuralı uygulanır. (türevC[] / türevY[]) = (türevO[] / türevY[]) * (türevS[] / türevO[]) * (türevC[] / türevS[])

Burdaki tüm türevleri kodumuzda "SecondLayerForBack(start, end)" ve "softmaxDerivative()" methodlarıyla gerçekleştirdik. Sonuç olarak 2. Ağırlık matrisimizi(Y[]) güncelledik.

Şimdi 1. katman için geri yayılım zincirleme kuralı uygulayacağız. Bu aşamada da "FirstLayerForBack(start, end)", relu türevi, "softmaxDerivative()" methodları threadler kullanılarak uygulanmıştır.

Sonuç olarak burda bir döngü oluşur. sürekli güncellenen ağırlık matrislerimizle elde edilen hata değerimize göre döngü ya sonlanır yada istediğimizi alana kadar dönmeye devam eder.

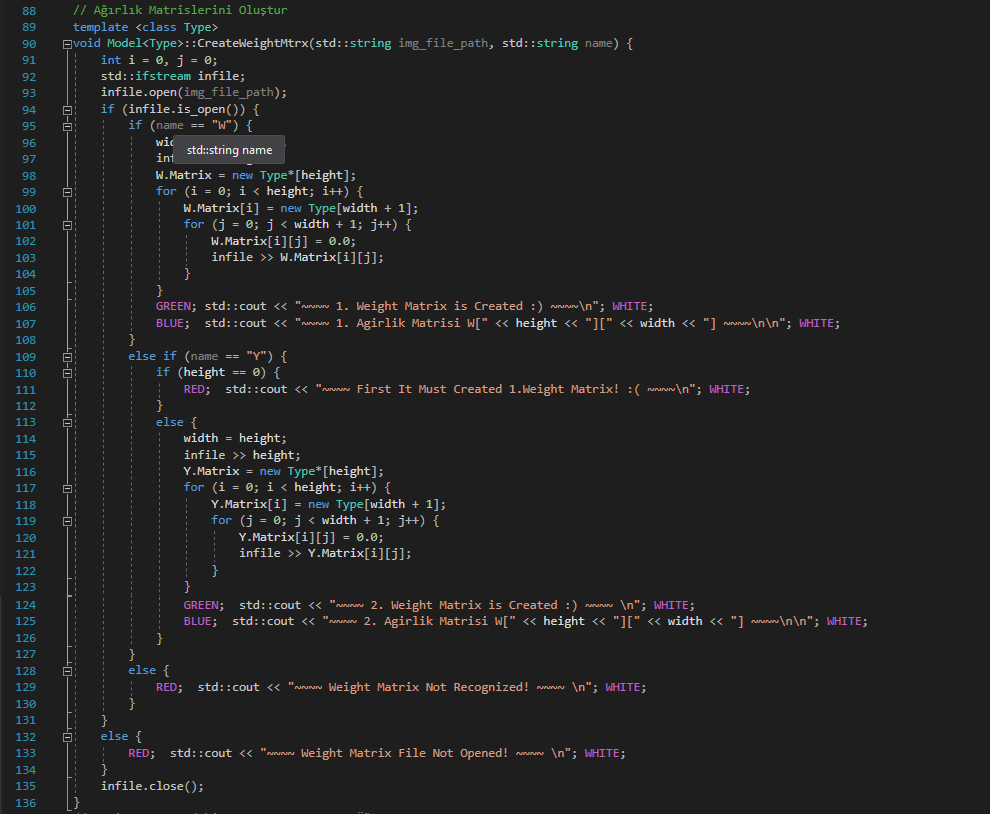

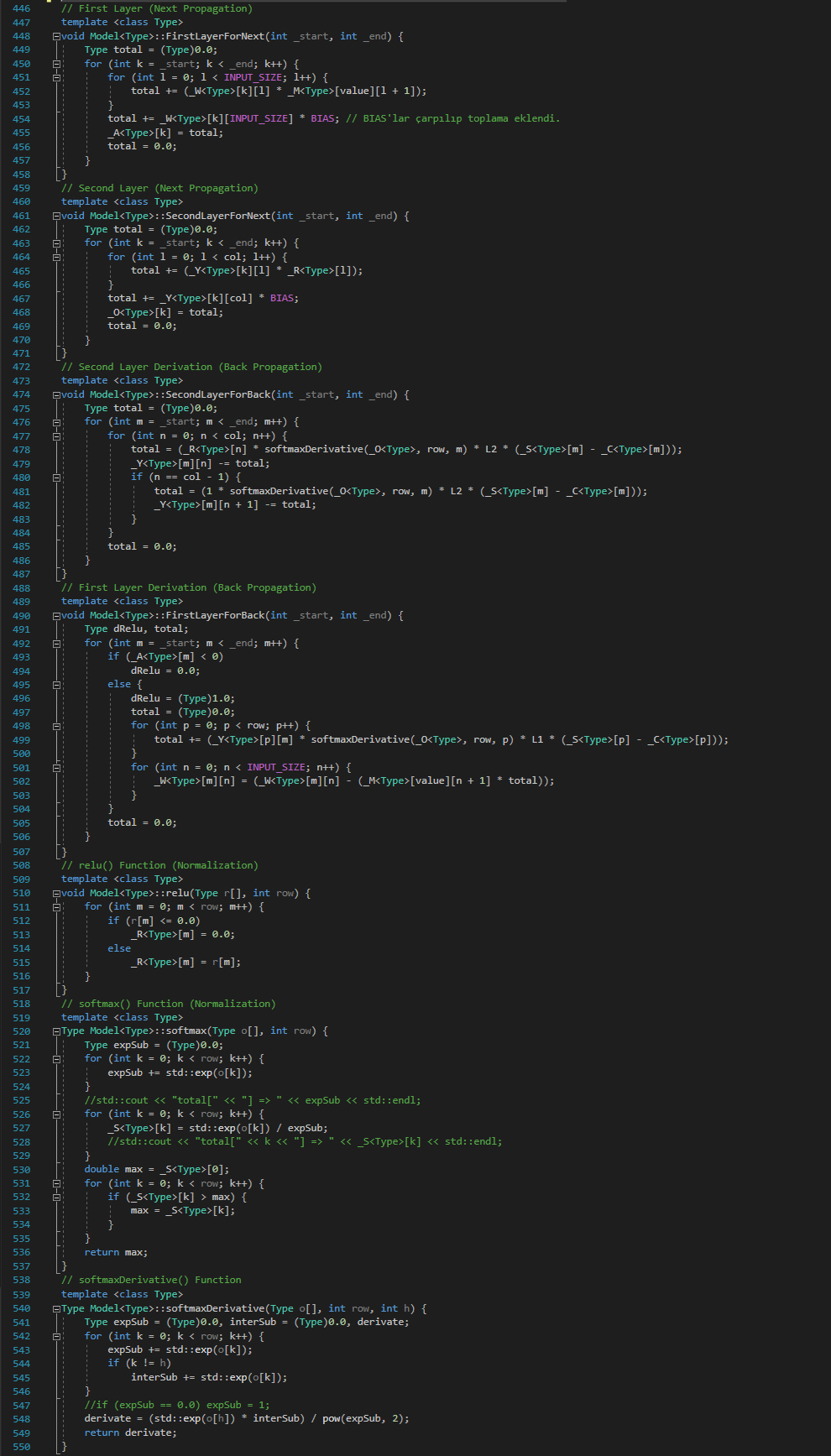

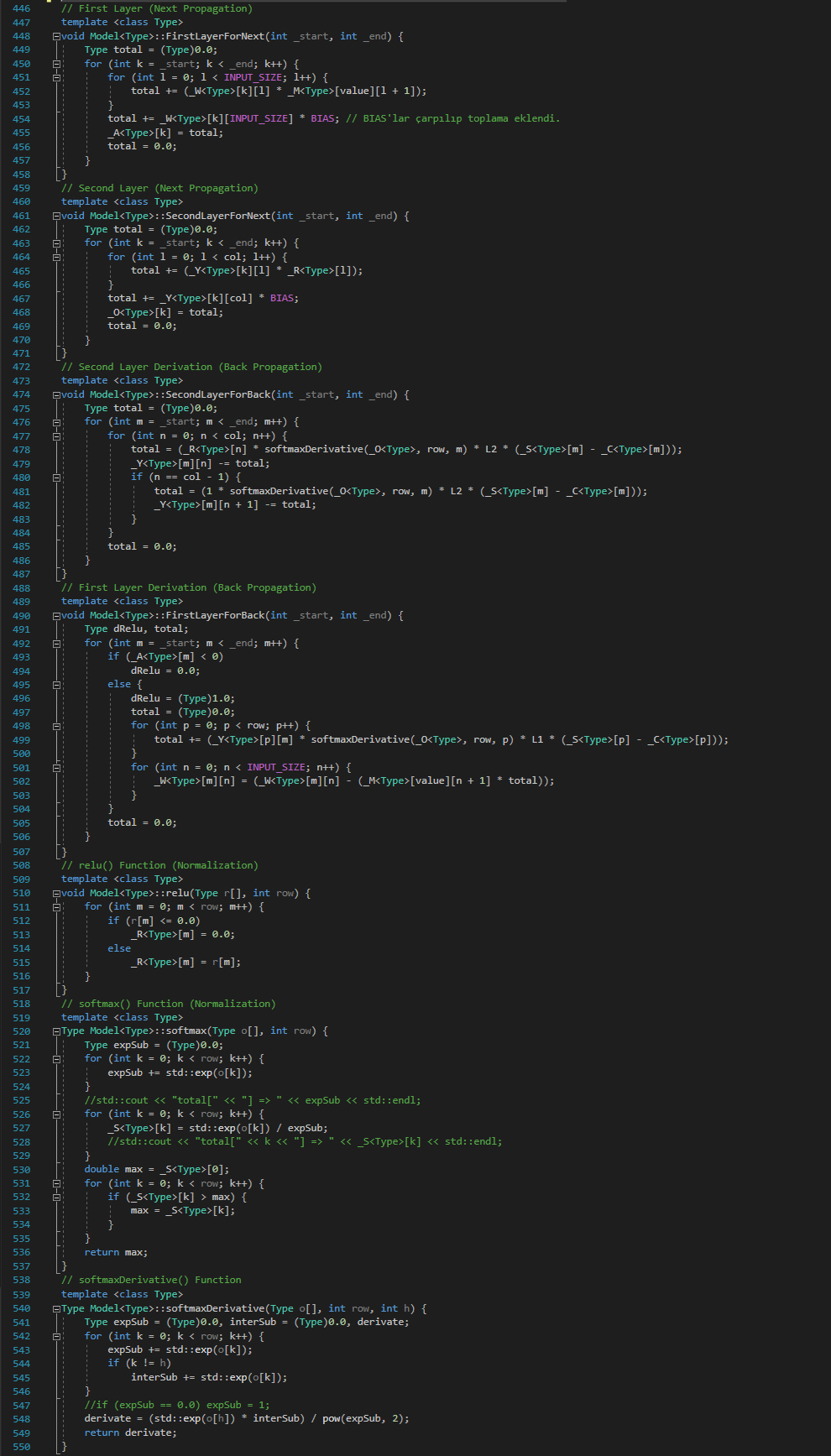

İleri Yayılım ve Geri Yayılım Aşamasındaki Katman Adım Methodları

"FirstLayerForNext(int _start, int _end)" İleri yayılım 1. katman matris çarpım işlemi methodudur.

Threadler kullanılarak blok veri paylaşımına göre yük dağılımı yapılmış ve method sorunsuz çalışmıştır.

"SecondLayerForNext(int _start, int _end)" İleri yayılım 2. katman matris çarpım işlemi methodudur.

"SecondLayerForBack(int _start, int _end)" Geri yayılım 2. katman zincirleme kuralı türev alma işlemi methodudur. Burada LAMDA2(L2) Öğrenme katsayısı kullanılmıştır. Bu katsayı deneme yanılmayla bulduğumuz sistem için en iyi sabit değerdir.

"FirstLayerForBack(int _start, int _end)" Geri yayılım 1. katman zincirleme kuralı türev alma işlemi methodudur.

Threadler kullanılarak blok veri paylaşımına göre yük dağılımı yapılmış ve method sorunsuz çalışmıştır. Burada LAMDA1(L1) Öğrenme katsayısı kullanılmıştır. Bu katsayı deneme yanılmayla bulduğumuz sistem için en iyi geri yayılım sayısına göre değişen değerdir.

"relu(Type r[], int row)" İleri yayılım 1. katman relu normalizasyonu uygulama işlemi methodudur.

"softmax(Type o[], int row)" İleri yayılım 2. katman softmax normalizasyonu uygulama işlemi methodudur.

"softmaxDerivative(Type o[], int row, int h)" Geri yayılım 1. ve 2. katmanda kullanılan softmax türevi işlemi methodudur.